“人間らしく”思考するAIをつくる

連載「進化するBIPROGY総合技術研究所」 第3回

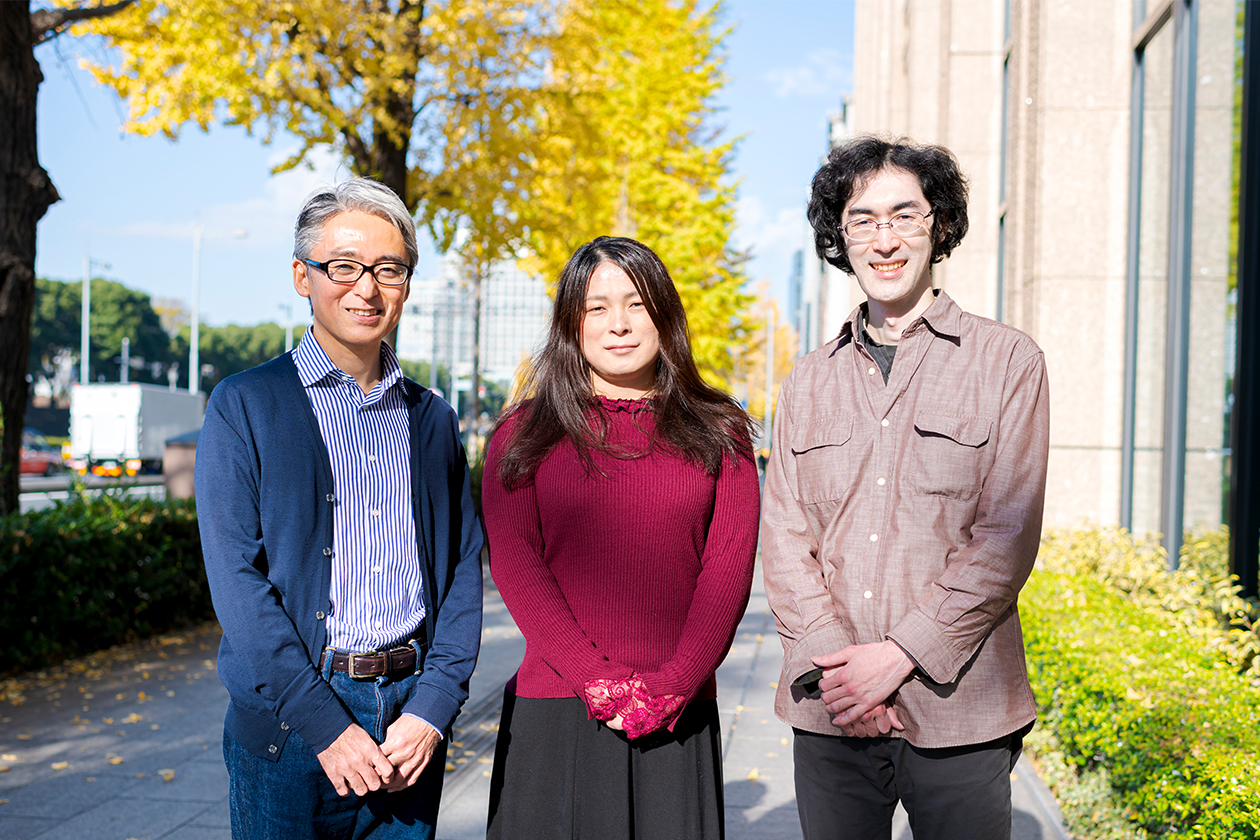

ChatGPTに代表される生成AIの登場によって、AIは人間にとって、以前よりもはるかに身近になってきた。一方で、人間とAIでありたい未来をつくるには生成AIだけでなく、あいまい性を扱うことができる新しい「論理型AI」が必要不可欠だという研究者がいる。今、AIはどのような課題を抱え、それを乗り越えるためには何が必要になるのだろうか。長年にわたってAIの基礎研究と、新しい「論理型AI」の実現に取り組んできたCリパブリックの研究員で博士の赤間世紀氏とBIPROGY総合技術研究所主席研究員で博士の中山陽太郎に話を聞いた。

AIが人間と同じように物事を解釈するには「論理」が必要

――お二人が取り組まれている「コンピューターで不確実性やあいまい性を扱う研究」とはどのような内容でしょうか。また、その目的はどんなところにあるのでしょうか。

中山私たちが研究しているのは「記号論理学」の分野で、人間の論理的思考を数式のような記号で表現して、コンピューターで処理できるようにする方法を扱っています。この方法は、論理型AIにも応用できると考えられています。

総合技術研究所 主席研究員 中山陽太郎

この分野に興味を持ったのは、仕事を通じて「データベースとAIは基本的に同じもの」と考えたことがきっかけです。私は元々BIPROGY(当時 日本ユニシス)で、メインフレーム(基幹システムなどに用いられる大型コンピューターシステム)のデータベース技術者として経験を積み、その後米国Unisys製やOSSのオープン系データベースの開発や保守に携わってきました。データベースの技術として重要だと考えたのは、整合性の取れた正しいデータを扱うことでした。そして「データベース技術を掘り下げ、ビジネスにも柔軟に活用できないか」と考えるようになりました。そんな時、先ほど述べた「データベースとAIは基本的に同じなのでは」との仮説を持ち、論理型AIの勉強会に参加し始めました。そこで赤間先生と知り合い、ご指導いただくようになりました。

AIには、与えられた各種命題の中身を確認して推論の正しさを確かめる述語論理(※1)が使われ、「真と偽(正しいか、正しくないか)」の判断は可能です。ただ、その観点だけでは捉えにくいグレーゾーン、つまり「あいまい性」を扱うことができません。

- ※1述語論理…命題の中身まで見て推論の正しさを確かめていく方法

しかし、人間の判断には主観が含まれ、その多くにはあいまい性も内包されています。AIがその部分を処理可能にするためには、あいまい性を踏まえた研究・技術発展が必要です。赤間先生の研究は、このあいまい性を反映できるAIを発展させていくことを目指すものでした。私たちの取り組んでいる論理型AIは不確実な状況における認識を表現するために発展したもので、あいまいさや矛盾を扱うことができます。私は論理型AIの実現に当たり必要となる理論と応用を研究し、2020年に博士号を取得しました。この研究をまとめたものを、2023年にSpringer Nature社より書籍として出版しています。

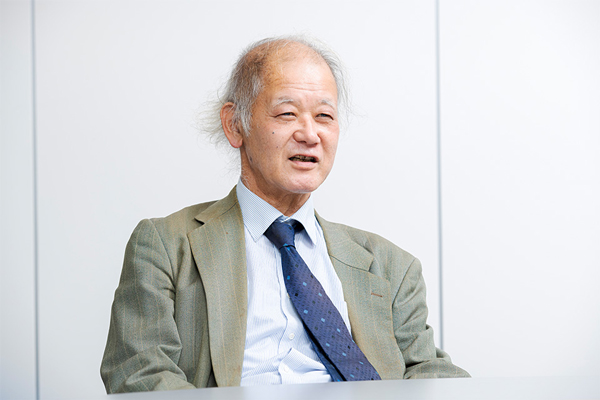

赤間私は元々大手IT企業でCOBOLやFortranなどのプログラミング言語を研究していましたが、機械翻訳を知るようになってAI、特に自然言語処理に興味を持ち、帝京平成大学や筑波大学大学院などで研究を続けてきました。

赤間世紀氏

自然言語処理では文法を扱いますが、言葉の意味が分かっていないと正しい解釈はできません。そこで、その言語の意味のモデル化のために論理学を研究するようになりました。それゆえ、質問の意味を考えないで答えを出してしまうディープラーニングには疑問を持っています。実際に今話題になっている生成AIでは、記述した質問の仕方によっては、全く意味不明な答えを出すケースもあります。確かに実社会で役立つ部分もありますが、問題を引き起こす可能性もあり、私たちが求めてきた理想のAIの在り方とは異なると考えています。

――確かに、生成AIは大きなインパクトを与える一方で、倫理的に問題になる回答や間違った回答をするリスクも指摘されています。健全に発展させるには論理的な裏付けが必要だということでしょうか。

赤間人間にとって、真か偽かは、先ほど中山さんが述べたように「正しいか正しくないか」あるいは「ゼロかイチか」だけではありません。解釈次第で何が正しいかが変わる場合もある。その折り合いをつけるのが論理学です。コンピューターの分野は、主に2進法が用いられる世界で、これは真偽の2値に基づく「古典論理」と言われます。しかし、この真と偽の間に、さまざまな可能性や「未定(※2)」などを幾層にも設けることで論理の段階を拡張し、人間の持ついわゆる“ファジー”な部分を捉えることができるようになります。

- ※2未定…数学の証明において、ある命題が真であるか偽であるか(証明可能か否か)まだ確定していない状態。例えば計算中の関数や未来を表す命題の真理値のこと

そして、その方が、人間が推論を働かせる際のやり方に近くなります。これらを扱うのは「様相論理学」の分野です。可能性と必然性からアプローチして、知識、時間、義務といった必要な記号を追加した論理型AIモデルが構築できれば、質問をより正確に解釈することが可能になります。

理想とするAIの姿はまだ実現されていない

――「AI」という言葉が最初に登場してから約70年がたちますが、まだまだ完成の域には達していないということですね。現在はどんな段階にあるのでしょうか。

赤間この言葉が最初に使われたのは、1956年にアメリカのダートマス大学で開かれた会議の場でした(その時はAIではなく「Artificial Intelligence」)。これは世界初のデジタルコンピューターENIACが開発されてからわずか10年後のことです。その後、1970年代には必要な理論はあらかたそろい、1980年代には第5世代コンピューターと呼ばれる日本の国家プロジェクトによる人工知能研究の登場もあり、AIが実現できるのではと期待が高まりました。

ただ、当時のコンピューターの能力では計算が遅すぎて、何の役にも立たないと判断され、AIそのものが役に立たない学問だと見なされるようになりました。これが第2次AIブームの頃の話です。ところが、2000年代に入って、コンピューターの計算能力が飛躍的に向上し、ニューラルネットワーク(※3)などの理論が実現できる可能性が高まり、商用システムが次々に登場しました。その後、大規模言語モデルも実用化され、現在は第4次AIブームに入っています。

- ※3ニューラルネットワーク…人間の脳内にある神経細胞(ニューロン)とそのつながり(神経回路網)を人工ニューロンという数式的なモデルで表現したもの

中山第5世代コンピューターには賛否がありましたが、確かにAIにとっては冬の時代が続きました。ただ、その期間も関連性の高い数理研究は継続されていました。私自身がAIの研究を始めたのは1990年代初頭のことですが、当時は思考を捉える手法にも限界がありました。

そこで登場したのが、赤間先生も貢献されてきた「直観主義論理」です。命題を「真か偽のいずれか」と考える古典論理と異なって、「真と偽の間に無限の領域がある」と考えるものです。命題に対して多様な認識を追加して表現する様相論理学などもその1つ。1990年代から2000年代にかけてこうした非古典論理学が発展し、“冬の時代”と言われながらも理論的にはAI研究が発展していきました。論理発展とコンピューターの処理能力の進化が相まって、1970年代からあったニューラルネットワークをAIの学習に応用可能となり、現在のブレークスルーにつながったのです。

しかし、今の生成AIはビッグデータをニューラルネットワークで学習することで、もっともらしい回答を返してきますが、その背後にある意味は捉えていません。意味を理解しないまま、記号として用いた言葉をつなげて、あたかも意味のあるもののように見せているわけです。これに対して論理型AIは、人間が持っている概念を元に命題の意味を正しく捉えて、記号に意味を与えることを目指すものです。

赤間もう1つ、論理型AIが持つ大きなポイントは与えられた意味を使って推論し、結論を導き出す「アブダクション」という考え方を用いていることです。生成AIでは、常識的な知識から一般的な規則を求める帰納的な推論は得意ですが、アブダクションは帰納推論とは異なり、仮説を推測する創造的な思考です。生成AIに見られるような、導き出された結論から見て全体が正しく構成できているかを判断する方法とは逆のアプローチです。そのため、論理型AIでは、導き出された結論からAIが意味を正しく理解しているかを確認することができるようになります。

AIに意味を理解させて意思決定で活用を

――AIが抱えている課題を解決するためにどんな研究をしているのでしょうか。

中山私のアプローチとして、論理型AIの研究をベースにしつつ意味の捉え方を補い、記号に意味を与えるために汎用的なデータ分析の手法である「ラフ集合論」を応用し研究に取り入れてきました。ラフ集合論とは、近似的に集合を分類し、対象の粗さを表現することであいまい性を扱えるようにした理論です。人間の抽象化や具象化の思考に即した処理に応用できるもので、赤間先生と公立千歳科学技術大学の村井哲也先生が先駆的な研究を行い発展させてきました。近年はラフ集合論に加え、意味の真理的な度合いを表現する注釈論理も併用して推論を行うことで、コンピューターが意味を理解できることを目指しています。

赤間注釈論理についてもう少し説明しますね。例えば、Aという命題が真か偽かと考える時に、未定や矛盾を表す真理値の要素からなる注釈の集合を持たせることで判断をファジー的に、つまりあいまい性を表現できるようにするものです。

――なるほど。では、「あいまい性」を理解する能力は、どのような分野でAIを活用する時に、効果を発揮するのでしょうか。

中山例えば、人間の意思決定が必要となる分野です。1つの命題に対してさまざまな注釈を付け加えることで、意思決定者にとって「望ましい」と「望ましくない」という両方の度合いを多角的に表現できるので、幅広い視点からの評価が可能になります。これを意思決定に使うと、多様な意見や諸条件を考慮しながら、重みを評価して合計し、判断の信頼度を表現できます。これは、異なる意見を持った人の判断を数値化したことと同じといえます。

注釈論理に基づく論理型AIは、ある情報を単純に正しい、正しくないに切り分けるのではありません。専門的知識に基づいて、情報の中に含まれる矛盾した状況や内容も判断しつつ、その内容を人間が直感的に理解できるような形で、高い信頼性を持った表現を可能にします。応用の1つの形として、ベテランや各分野のエキスパートの暗黙知を形式化することにも適しているでしょう。一方、生成AIは記号からのみの学習であるため、暗黙知は扱えないのです。

赤間医療診断の領域も有効な分野です。以前、人間の判断を支援するためのエキスパートシステムが数多く登場しましたが、医療診断については厳密なモデル化はされませんでした。理由は、入力された質問の意味を正しく解釈できなかったからです。例えば、体温は数値化されていますが、「痛い」というのは数値で測れないあいまいな表現です。そのため、コンピューターでは判断することができなかったのです。

また、最近では医療情報の膨大なデータがあり、分析疫学における手法の1つであるコホート研究ではそれらのデータから地域による病気の傾向を分析して、医師の診断に役立てることができます。しかし、そのデータを利用する医師のスキルや考え方でも診断結果が異なり、その上、同じ診断であっても説明を受ける患者によって受け取り方が変わる可能性もあります。

物事を判断する際にある程度の段階までデータを利用する点では経営戦略システムに近いものがありますが、医療の世界では生命という大きな責任を伴うため、簡単に失敗した時の言い訳にはできない。そのため、いくら膨大なデータがあっても、今の生成AIに任せることはできず、医療診断では有効に使われていません。この問題に、今研究しているラフ集合論や注釈論理といった基礎的な論理がいずれ役立つと思っています。

倫理観や道徳観を持つことでAIは人間を支援できる

――これからのAIはどう変わっていくのでしょうか。また、そこでお二人の研究はどう生かされるのでしょうか。

中山言語的会話の技術はChatGPTの登場で大きく発展しました。ただ、表面的な記号をつないだ確からしさがあるだけで、本質的には理想のAIには近づいていません。これから求められるのは、意味を理解することで倫理観や道徳的判断を支えることです。例えば、自動運転で自律的な判断ができるようになるには倫理的、道徳的な判断が必要。どちらに曲がっても事故が起きてしまうような状況では、選択肢の価値を判断し進む方向を決めなければなりません。意味を理解し、推論から未来の出来事を予測し、意志を持って判断することが求められるのです。AIが倫理的、道徳的な価値観を持って判断できるようになれば、人間とAIで本当の意味での会話が成立します。そのために道徳的な判断を行う基礎として注釈理論とその拡張に取り組んでいきます。

赤間AIにまつわる話題の1つに「シンギュラリティ」があります。つまり、AIが人間の能力を上回るようになる、というもの。「本当にAIが人間を上回れるか」などはまだ理論的には検証されていません。AIが道徳観を持つのかどうかも同じです。「すでにAIは人を上回っている」と言う人もいるかもしれません。しかし、AIが自律的に進化して、人間を敵と見なして奴隷にしようと考えなければ、人間を上回ったことにはならないと見ることもできます。今、そういう理論はできていないわけです。また、「正解を回答できれば良い」と考える一部の研究者は「すでにAIは完成した」と言うかもしれません。しかし、まだ実用化されていないものの、高速で計算ができる量子コンピューターがあり、自律性のようなAIの基礎となる人工生命の研究も進んでいます。これらのことも踏まえて総合的に発展させないと真の意味でのAIにはならないでしょう。

――AIが道徳を理解し人間らしさを持った時に、人間とAIはどう共存していくのでしょうか?

中山全知全能になったAIが自分の判断で動き出すと、単なる道具ではなくなり、人間の言うことを聞かなくなる恐れもあります。それを防ぐためにも、ロボット三原則にあるように、必ず人間を守り助ける存在になることが理想です。現実世界でも人間の道徳は測りきれないものですが、道徳心を持つことは自律的な行動に責任を持つことでもあります。その意味で今のAIには責任能力が欠如しています。人間とそっくりに振る舞っても、その実は吐き出される文章に意味も意図も持たない「ゾンビ状態」。道徳心を持っているのかどうかも分かりません。だからこそ数値や論理の面から道徳を研究して、AIの意思決定に取り入れていくことが大事なのです。

赤間AIが常識を持つことは、人間が考えていることをAIが理解することです。そうなることで、AIが人の能力を超えても人間がAIを使える社会になることが理想です。一方で犯罪の手口はAIによってより巧妙になるかもしれません。このままでは道徳的問題や社会的な問題が発生してくるでしょう。それは、道徳の定義が難しいから。例えば、会社の会議に遅刻しないで参加するという道徳を教え込まれたAIが、出勤途中に交通事故を目撃したとします。助けていたら遅刻しますが、道徳的な行為だからと助ける方が良いのが普通です。ただ、その会議にとってAIがとても重要で、遅刻したために会社が倒産してしまう場合はどう判断するか――こうした場合が難しいわけです。

中山重要なのは道徳の程度をどう見るか。医療や法務にAIを利用することができないのは、その説明が不十分だからです。道徳的な説明ができることによって、AIが出した結果が人間から受け入れられれば、お互いに信頼が生まれて実用化が進んでいくはずです。BIPROGYでは2020年2月に「AI倫理指針」を発表して以来、AI倫理がどうあるべきかを追求してきました。個人のプライバシーや多様性、公平性を損なうことなく、人間中心を前提としたAIの社会実装を目指すことが大切です。AIが適切な振る舞いをできるようにするには、道徳を数学的、論理的に示して、AIに内省的な推論能力を加え、記号に意味を持たせることが重要。人を理解したAIが人と共により良い社会をつくるような未来を創り出していくことが、私たちの大きな研究テーマです。

中山陽太郎は、知的意思決定支援に関する国際会議「14th KES International KES-IDT-2022」において最優秀論文賞を受賞しました(論文タイトル「Four-valued Interpretation for Paraconsistent Annotated Evidential Logic」)。本賞は、英国の知識工学を中心とする学会KES Internationalが主催する14th KES International KES-IDT-2022において最も優秀な論文に授与されるものです。

また、2023年5月に中山の博士論文をベースとした書籍がSpringer Nature社より発刊されました。『認識状況計算に基づく粒状化計算 - 常識推論への新たなアプローチ』(著者:赤間世紀、中山陽太郎、村井哲也・著/Springer Nature社/2023年5月)