対談:「人間中心のAI」の社会実装を目指して(前編)

AI倫理が問いかける「人とテクノロジー」の関係性

AI技術は、人々の生活向上に大きく貢献し始めている。その一方で、適切に利用、運用、管理されないことにより、個人のプライバシーや多様性、公平性を損なう恐れがあると指摘されている。そうした中、2019年3月に日本政府は「人間中心のAI社会原則」を発表。AIの社会実装に向けた広範な課題がクローズアップされた。日本ユニシスグループも2020年2月、「AI倫理指針」を発表し、未来に向けた新たな模索をスタートさせた。本稿では、AI活用に関するさまざまな問題を踏まえ、これからのAI倫理がどうあるべきかを、東京大学未来ビジョン研究センター特任講師の江間有沙氏と、日本ユニシス株式会社 フェロー CTO総合技術研究所長の羽田昭裕が語り合った。(以下、敬称略)

*本記事は2020年6月にリモート取材したものです。

AI活用の中で注目される

「品質保証」と「イノベーション」のジレンマ

羽田 AIの活用が社会に浸透する中、今倫理問題に注目が集まる背景には、ITシステムにAIが加わることで「かつてないリスクや品質上の課題が生まれる」という危惧があります。加えて、技術開発において、近年は多様なエンジニア層がAIを搭載したシステム開発に参画できる環境も整いました。さらに開発者の家からでもプロダクトを社会に発信できるようになり、ますますその懸念を深めています。これまで、大規模生産を前提としたプロダクトの品質担保やトラブル時の責任所在については、「製造物責任」などがありました。このため、AI活用においても「リスクや品質上の課題を克服するためには、技術開発に際して一様に規制を強めればよい」との動きもあります。しかし、私自身はそうではないと感じています。例えば、当社におけるイノベーションの萌芽は、多種多様なユーザー企業などとの共創関係から生まれることが多い。こうしたイノベーションの生成過程に規制を持ち込むメリット、デメリットは、まだ十分に切り分けられた議論がなされていません。江間先生はどのようにお感じでしょうか。

江間 AI活用を前提としたシステム開発・技術開発の面ではユーザーとベンダーも含めて垣根が曖昧な状況です。今のAI技術の主流でもあるディープラーニングも、ユーザーが加わることでデータの確保や社会実装に向けた改良が進みます。垣根が曖昧だからこそイノベーションも進みやすい。その一方、「トラブルが発生した際の責任は誰が負うのか」という点は曖昧です。ただ、これまで加速度的に社会を変えてきたIT技術分野一般でも、同様の課題を少なからず抱えていたのではないでしょうか。

特任講師 江間有沙氏

羽田 まさにそうです。私は何十年間も決着がつかなかった諸課題を一気に整理するよい機会と捉えています。もともとソフトウェア文化には、使用者責任と製造者責任が曖昧な「無法状態的な部分」があったと感じます。現在は、開発の中にAI活用が進展することで、棚上げしてきた課題点が数多く露呈したと考えています。私は、これをきっかけに、責任の切り分けについての考え方を明確にして次世代にバトンを渡したいという気持ちを持っています。

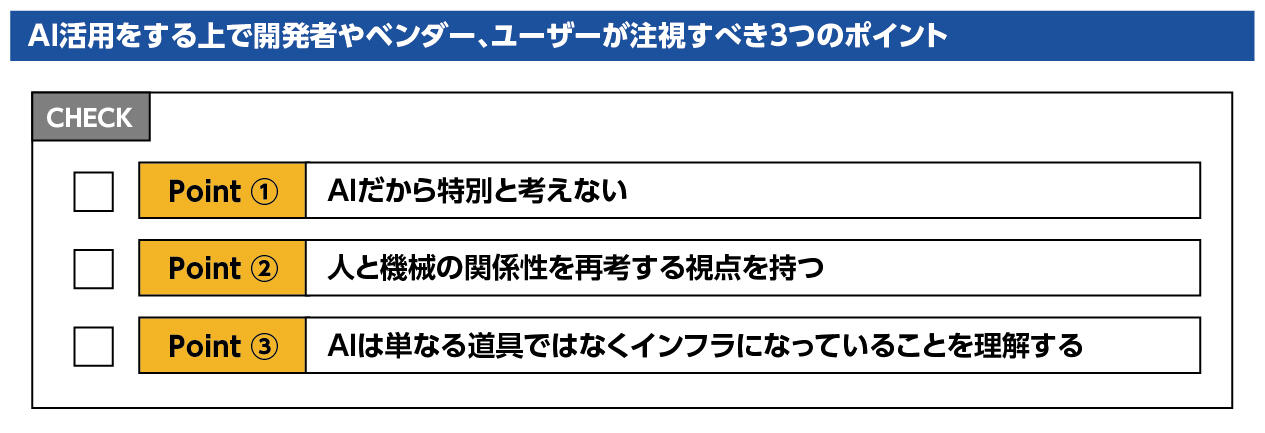

江間 議論すべきポイントは3つあると思います。まず「AIだから特別と考えない」ことです。AI活用に関する法規制や倫理的課題への対応は、ITシステムやデータの扱いに関して今まで積み重ねられてきた議論を踏まえることが大切です。AIにだけクローズアップした対処法では、「我々が作っている/使っているのはAIではない」ということで規制や運用の「抜け穴」が生まれる恐れがあるからです。次に「人と機械の関係性」を再考する必要があります。先ほどの人と機械の責任配分の問題だけではなく、「個人とは何か」を改めて考える必要が出てきています。例えば、故人のデータは現在、個人情報保護の外にありますが、亡くなった方のさまざまなデータを用いて再現するような技術があります。これは情報倫理だけではなく生命倫理の問題とも関連してきます。そして、最後に「AIは単なる道具ではなくインフラになっている」と理解することです。民間だけではなく、医療や交通、法執行分野などの公共分野の意思決定支援にもAIが使われ始める中、プライバシーやセキュリティ、公平性を巡って公共と個人の利益のバランスを考える必要があります。COVID-19対策でもこのバランスは重要な視点です。

情報倫理だけではなく、

生命倫理の視点も踏まえてAI倫理を捉える

江間 日本ユニシスとしては、こうしたAI倫理の諸課題をどのように捉えているのでしょうか。

フェロー CTO 羽田昭裕

羽田 江間先生には、AI倫理に関する三井グループの研究会でお世話になりました。この会での検討も踏まえて、2020年2月に日本ユニシスグループとしての「AI倫理指針」を打ち出し、今後の技術開発にAIを適用する際に守るべきことを公表しました。議論の出発点は、「AI活用では無自覚のうちに人の身体や思考、行動に介入してしまうこと」にあります。それを設計する技術者が無自覚なまま、このセンシティブな領域に踏み込んでしまう恐れがあります。この点にとどまらず、ステークホルダーの多様な関心への配慮も求められることから、技術者個々人の努力だけでは解決できない事象をカバーする点が、当社のAI倫理指針の肝になっています。また、AI活用を巡る議論の焦点は、生命倫理に近い様相を呈してきました。そこで、当社では「生命科学研究倫理審査委員会」という組織を構築して対応しています。

江間 一般的に指針は「作って終わり」になりがちです。うまく使えたとしても、形骸化していく可能性も残ります。また、自由なイノベーションを阻害することにもなりかねません。そこはどのようにお考えでしょうか。

羽田 繰り返しになりますが、イノベーションは多様な背景を持つユーザーとの共創関係の中から生まれると考えています。それに基づいてステークホルダーとの関係を重視することで時代との緊張感を保ちつつ、AI倫理を考える中で浮上する倫理的な課題については生命科学研究倫理審査委員会との連携を通じてイノベーションとのバランスを図ろうとしています。

AI倫理を起点に

人間と技術の関係性を問い直す

江間 先ほど「AI活用と生命倫理領域の近接」というお話もありましたが、AI倫理を考える上では「人権」や「人間の尊厳」を捉える際の視点が重要だと思います。例えば脳死した場合、「自分の臓器をどのように使ってほしいか」を意思表示するカードがあるように、死後、自分の情報をどう使ってほしいかを、自分や周辺の人たちのメリット、デメリットを考慮して意思表示するような仕組みを提示する議論が始まっています(参考:D.E.A.D[Digital Employment After Death= 死後デジタル労働])。

羽田 当社は、内閣府の戦略的イノベーション創造プログラム「AIホスピタル」に参画しています(参考:「AIホスピタル」が引き起こす医療革命)。そこでは、江間先生がおっしゃる通り、インフォームドコンセント(十分な説明と同意)の場面の中で、AI活用によって患者さんをいかにサポートするかも議論となっています。「どのような使い方をすればクライアントは納得するのか」「どのような伝え方をすればよいか」などです。この議論から浮かび上がるのが、どのような技術を作っても「利用者側が何を求めているのか」「提供側が何を軸にするのか」が、整合していなければ現実的に役立たない点です。つまり、「人間とIT技術の関係性」を見つめ直す本質的な問いです。

江間 私も伝え方と受け取り方の議論は重要だと感じます。「技術を受容してもらうにはどうすればよいか」という質問をよくされますが、一方向的な考え方だと思います。伝え方、受け止め方によって人々の技術に対する反応は異なってくるので、相互にコミュニケーションを図っていくことが大切ではないでしょうか。

羽田 私たちソフトウェアの専門家の仕事は、解きたい問題を特定した後、その解となるシステムを設計してプログラムを開発することです。この作られたプログラムが、利用されることを通じて、新たな問題を生み出すというのは、ソフトウェア工学の基本的なテーマの一つでした。AI活用では、そこが先鋭的な焦点となるわけですね。これは設計やアーキテクチャではなく、プロセスとして対処するのがよさそうです。しかし、AI倫理において、このプロセス技術については十分に議論されていないように感じます。

江間 おっしゃる通りです。開発から利用に至るまで関係者が対話できる場のデザインやツールが必要となってきます。しかし、ただ単に情報を開示、説明すればよいというものでもありません。また、AI技術の開発者とサービス提供者が異なる場合なども多いため、単一の企業だけでは対応できない部分も出てきます。そのため、業界団体でのガイドライン作りや、国同士、国と企業の間、さらにはユーザーも巻き込んでベストプラクティスを作っていくことが重要になります。さらには、「問題は必ず起こるもの」という前提で、監査や保険などの仕組みも一緒に開発をしていくことが重要になります。

羽田 興味深いですね。AIの判断プロセスに固執してしまうと品質の担保や利便性の向上という本質的な価値が見失われてしまうということもあるでしょうから。

江間 例えば、「企業の採用判断をAIに支援させる」と言うと、多くの方は「AIの仕組みがブラックボックスだと困る」と中身を知りたがります。一方で、同じ大学の出身だからとか、直感的にいいと思った、など人間の判断のほうがよっぽど不透明な場合もあるわけです。人間の判断だと不問にされてしまうものも、機械の判断と言われると途端に許せなくなるのはなぜか。品質の担保の在り方を改めて考える必要があると思います。

羽田 IoTの社会実装でも同じようなことが起きています。実証実験はよいけれど、現場に持ち込もうとすると、導入によって起きる否定的な面が明らかになることが多い。人間との関係を踏まえて、AIやITという人工物全般の責任問題を再構成していくことが今後求められてくるのでしょう。

>> 後編(「AI倫理ガイドライン」に表出する企業理念)に続くProfile

- 江間 有沙(えま・ありさ)

- 東京大学未来ビジョン研究センター特任講師

- 2012年東京大学大学院総合文化研究科博士課程修了。博士(学術)。京都大学白眉センター特定助教、東京大学教養教育高度化機構特任講師、政策ビジョン研究センター特任講師を経て2019年4月より現職。人工知能やロボットを含む情報技術と社会の関係について研究。主著は『AI社会の歩き方-人工知能とどう付き合うか』(化学同人、2019年)。

- 羽田 昭裕(はだ・あきひろ)

- 日本ユニシス株式会社 フェロー CTO

- 1984年、日本ユニバック(現・日本ユニシス)入社。研究開発部門に所属し、経営科学、情報検索、ニューロコンピューティング、シミュレーション技術、統計学などに基づく新たな需要予測技術などの研究やシステムの実用化に従事。その後、Web関連や新たなソフトウェア工学に基づく開発技法の理論やアーキテクチャの構築、製造業や金融機関を中心とする企業システムのITコンサルティングなどを担当する。2007年、日本ユニシス総合技術研究所 先端技術部長、2011年から総合技術研究所長に就任。2016年から現職に。