対談:「人間中心のAI」の社会実装を目指して(後編)

「AI倫理ガイドライン」に表出する企業理念

近年、AI技術の進化は人々の生活向上に大きく貢献し始めている。この一方、個人のプライバシーや多様性、公平性の担保が世界的に議論されている。こうした流れの中、日本政府は2019年3月に「人間中心のAI社会原則」を発表。日本ユニシスグループも「AI倫理指針」を2020年2月に発表し、未来を見据えた動きをスタートさせた。 東京大学未来ビジョン研究センター特任講師の江間有沙氏をゲストに迎え、AI倫理をテーマに、日本ユニシス株式会社 フェロー CTO総合技術研究所長の羽田昭裕がともに語り合った対談企画。後編となる本稿では、国際的な潮流も俯瞰しながらAI倫理を機能させ、社会実装を進めていくためのポイントを探ってみたい。(以下、敬称略)

*本記事は2020年6月にリモート取材したものです。

>> 前編はこちら

「AI倫理」を巡る議論の潮流は

“What”から“How”へ

羽田 2019年3月に内閣府が策定した「AI社会原則」には、「人間中心の原則」が盛り込まれてクローズアップされています。こうした動きをどのようにご覧になっていますか。

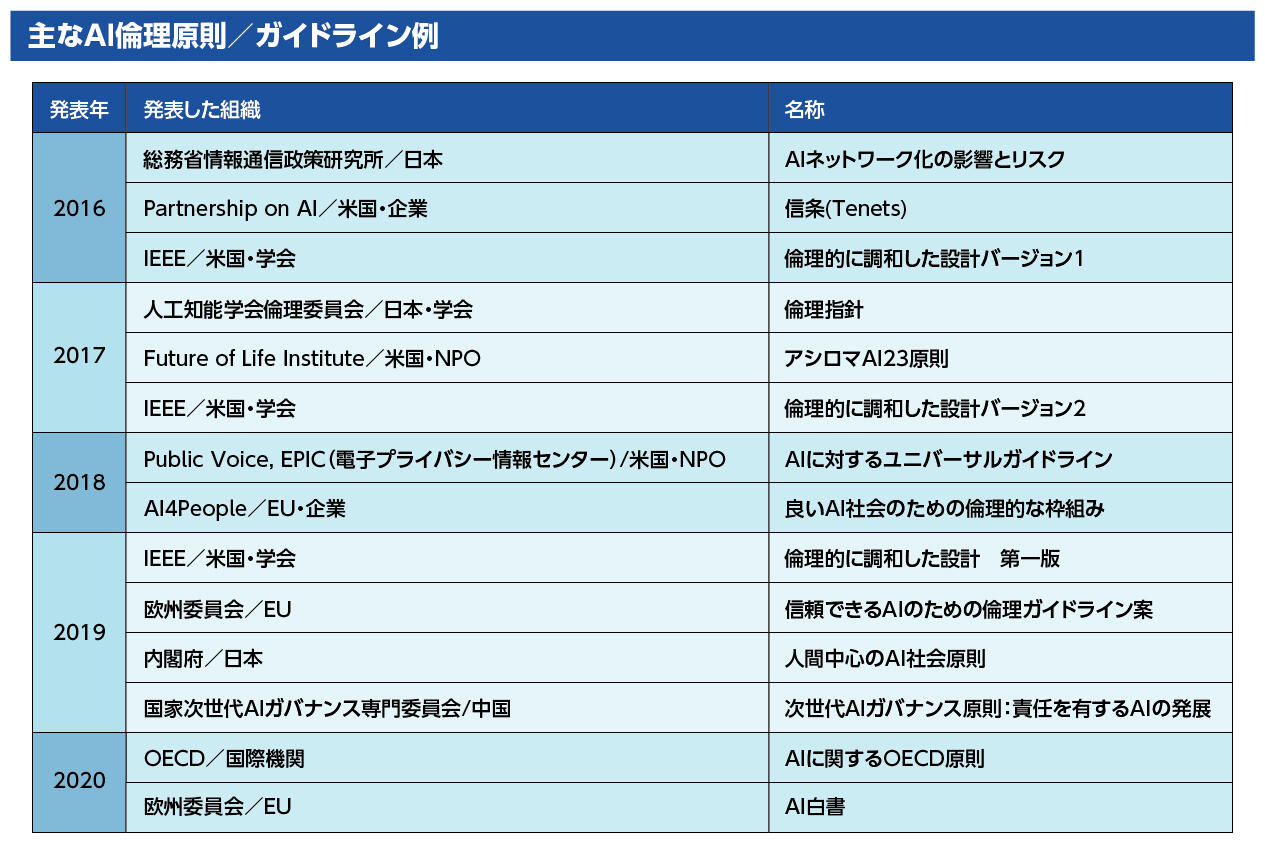

江間 AI倫理については、2016年あたりから米Google社やFacebook社といった企業のイニシアチブから始まった「Partnership on AI」や、米国に本部を置く電気・電子技術に関する学会「IEEE(Institute of Electrical and Electronics Engineers)」などで議論されるようになってきました。これらの活動は産と学だけではなく、また、AIの研究者をはじめとした多様な分野の研究者や実務家も巻き込んで展開していきます。そして2017年には、産学官民の人々の議論の結果として、人類にとって有益なAIに関する「アシロマAI 23原則」がNPO法人Future of Life Institute (FLI)から発表されました。最近では、何が議論すべき論点なのか(What)に関する世界的なコンセンサスが生まれ始めています。内閣府の人間中心原則もこれらを踏まえたもので、世界ではすでに100近くのガイドラインが発表されています。次のステップとして、これらの論点や価値、課題をどのように各企業が実装していくか(How)に焦点が移ってきています。会社内部でチェック機構を設けるところもありますし、一方で国によっては政府調達に参画可能な企業の前提を「AIガイドラインや運用の有無」とするところも出始めています。

羽田 確かにそうした動きは増えていると実感します。当社もAI倫理規定を策定し、その実装を進めているところです。

フェロー CTO 羽田昭裕

江間 一方で懸念事項もあります。例えばグローバル企業であれば、政府調達に参加するためなどのビジネス上のインセンティブもあり、AI倫理への取り組みが期待できます。しかし、ローカルでビジネスしている中小企業やスタートアップでは人手やノウハウが不足しているかもしれません。また、AIのアプリなどでは個人でも開発が可能です。

羽田 確かに、スタートアップや個人の開発した技術を大企業が採用するケースも多くあり、そこまで対象としていくと、一企業では手に余りますね。難しい課題です。

特任講師 江間有沙氏

江間 これに加えて、現在のAIガイドラインの多くがAI先進国で作成されていることにも注目する必要があります。何を議論する必要があるか(What)の議論に参加できていない国のほうが、実際には多いのです。一方で、AI導入の面では、それまでシステム導入を行っていない新興国のほうが早く広がる場合があります。そこにはAI先進国の策定したガイドラインが適用されます。文化差や経済格差などを無視して先進国の価値観が一方的に押し付けられてよいのかという疑問から、WHO(世界保健機関)やユネスコ(国連教育科学文化機関)がWhatを考える段階から、アフリカや中東、アジアなどさまざまな国を巻き込んだ共通ガイドラインの作成に乗り出しています。

羽田 確かにHowに踏み込もうとすると、事実認識と価値判断が一層深く問われます。落とし込む際には、これまでのプラクティスを基準とするのか、まったく新しい基準を作るのかが悩ましいところです。当社でも「AIの品質保証は新しいものとして捉えるのがよいのか」「既存の品質保証の延長と捉えるべきなのか」は議論をしてきましたが、既存の品質保証の概念の上に、AI倫理を構成することにしました。

「最適解」が存在しない

AI倫理の世界

江間 AI技術そのものや懸念は、社会の変化やそれに伴う人間の意識変化によっても変化し続けます。最適解は存在しませんから、「ベストプラクティス」ではなく、「ベターなプラクティス」を追いかけるしかありません。また失敗もきちんと記録しておいて、繰り返さないように共有することも重要です。AI倫理ガイドラインはそのための基盤として捉えるべきです。

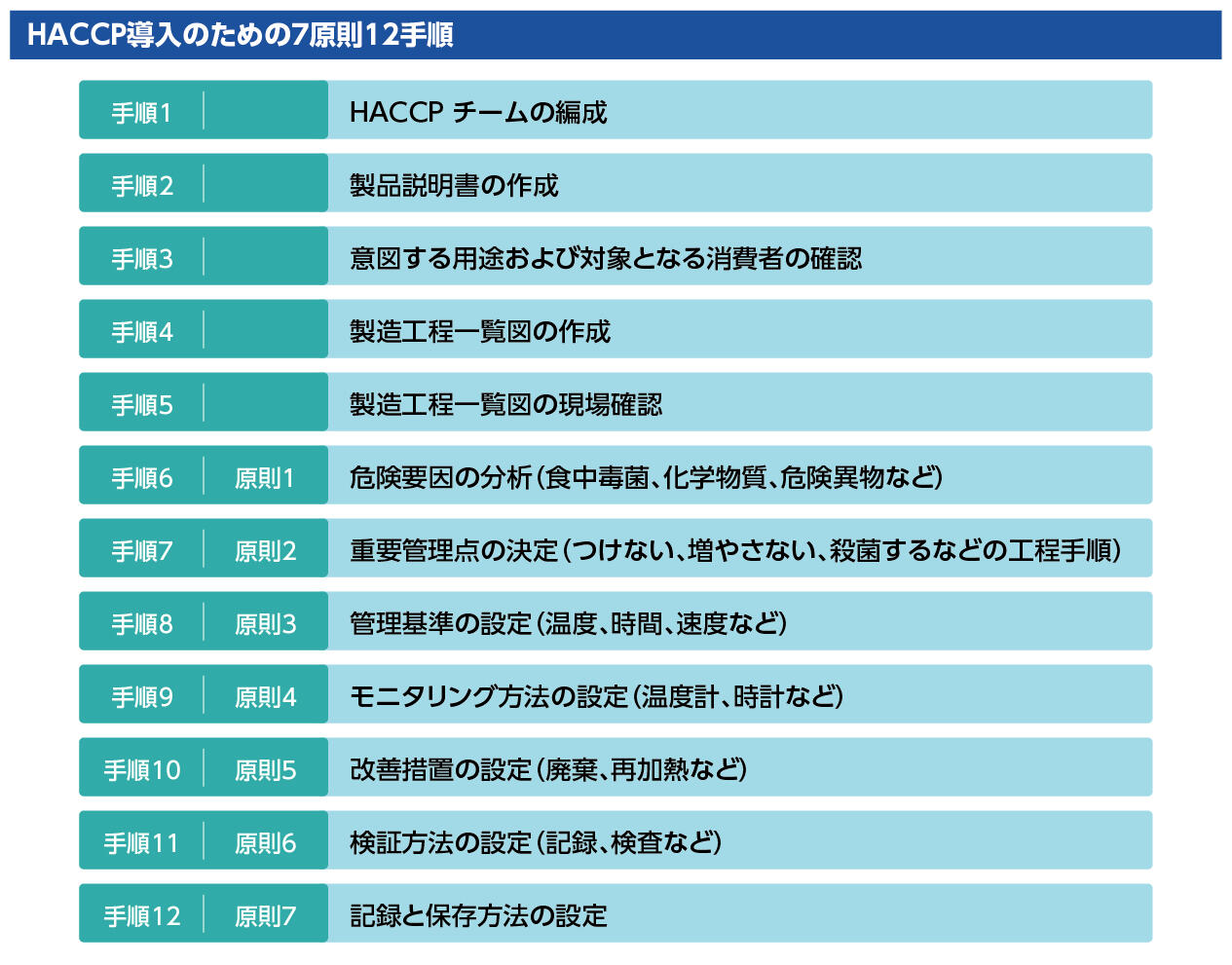

羽田 今年6月に義務化された食品安全のための衛生管理手法である「HACCAP(ハサップ)」と似ていますね。私が、品質と安全文化を考えるフォーラムに参画していて感じるのは、長い時間をかけて、実務者を巻き込みながら国際的に議論を積み重ねているという点です。品質管理に取り組む人たちは、しっかりとつながっています。AI倫理についても、それ位の時間を見たほうがよいかもしれませんし、そのための人的ネットワークがあるとスムーズに行くのではないでしょうか。

江間 確かにそうですね。ただ、その前提として「言語の共通化」も大切です。同じような言葉を使っていても、意味が異なる場合もあります。例えば「説明責任」は英語のアカウンタビリティーの訳とされていますが、これを「説明をする責任がある」と考えると、本来の意味を捉え損ねます。英語のアカウンタビリティーでは、何か問題が起きたときに誰が説明してどう責任を取るかが明確化されていることまで含みます。ただ単に説明をすればよいというものではないのです。なので「答責性」と訳すのが適切だと法哲学の研究者がおっしゃっていたりします。ちなみに中国ではアカウンタビリティーを「追責性」と訳すらしく、こちらのほうが英語の意味合いに近いかもしれません。

羽田 そういう中で倫理とは何かを議論するのですから、難しくなるのは当然ですね。当社がこれまでの品質保証の枠組みの上にAI倫理を構成したのには、既存の概念という共通部分をベースとしたほうが社内外に分かりやすいとの考えもありました。

AI倫理ガイドラインの議論には

多層的なリスク要因の構造化が不可欠

羽田 AIを扱う場合、IT技術者は人間の感情や身体に介入していることをもっと自覚する必要があります。今は無自覚のままやっているケースもあります。この点は、先にも指摘しましたが、そこで議論されるべきは統制のプロセスです。従来、ソフトウェアの品質はプロセス技術で保証しています。それは最終的には技術者の努力によって保証されています。しかし、AIではそのような努力では解決できない部分も生まれてきます。また、AIの「主役・脇役問題」も大きいと思っています。つまり、「AI倫理を考える際には、AIがシステムの補助的な機能なのか、中心となる機能なのかで捉え方が大きく違う」ということです。それによって統制に対する考え方も変わってきますね。

江間 AIを活用することで、どのようなリスクが増大するのかは、関係者間で把握することが重要です。ただ、AIが既存のIT技術と違って難しいのは、学習をしていくなどの特徴によって、定型的なチェックリストでは解決できない点やシステムや利用方法に合わせて、その都度シナリオを考えてデザインしていく必要があることです。この観点も踏まえ、先般「AIサービスのリスク低減を検討するリスクチェーンモデルの提案」と題した政策提言を出しました。リスク要因を技術的要素、サービス提供者の行動規範要素、ユーザー理解・行動・利用環境要素の三層に分類したリスクチェーンモデルを提案し、段階的なリスク低減の検討と効果的・効率的なリスクコントロールを検討する方法論です。現在、いくつかの企業とこのモデルを使った共同研究を展開しており、信頼性の高いAIサービスの実現に役立ててもらいたいと思っています。

AI倫理ガイドラインには

企業の理念や姿勢が現れる

羽田 最後になりましたが、私が今一番恐れているのは、今般の新型コロナ禍によって、AI倫理を巡る丁寧な議論が吹き飛ばされてしまうことです。新型コロナの感染拡大を防ぐことを名目に、さまざまなところでAI活用が急速に進展しています。以前からのAI活用への懸念や課題が払拭されていないにもかかわらず。AI倫理は忘れてはならない重要なイシューです。このコロナクライシスの後、「ニューノーマル」の時代が訪れたときに、将来を見据えたAI活用の面で、「何を残して何を捨てるのか」は慎重に決めていく必要があります。どさくさに紛れて規範的でない指針を定着させることは、長期的に見て避けるべきと考えています。冒頭でも思いをお伝えしましたが、最適な形で次世代にバトンを渡していきたい気持ちを持っています。

江間 確かに「ショック・ドクトリン(大惨事につけ込んで実施される市場原理改革)」は避けなければなりません。一方で、公共の安全や健康と個人のプライバシーといった問題の議論も丁寧にしていく必要があります。国や企業としても、個人としても今回のことは、AI倫理を包括的な視点で考えるチャンスです。企業のAI倫理ガイドラインには、企業ポリシーが反映されます。つまり、企業ブランドと同じです。この危機にAI活用やAIに関する倫理姿勢をどう捉えるのか、企業としての振る舞いが試されています。何が起きるのか分からない中で、いかに倫理的に適切、かつ柔軟に対応できるのか。それが試されるテストとして受け止めてほしいと思います。

Profile

- 江間 有沙(えま・ありさ)

- 東京大学未来ビジョン研究センター特任講師

- 2012年東京大学大学院総合文化研究科博士課程修了。博士(学術)。京都大学白眉センター特定助教、東京大学教養教育高度化機構特任講師、政策ビジョン研究センター特任講師を経て2019年4月より現職。人工知能やロボットを含む情報技術と社会の関係について研究。主著は『AI社会の歩き方-人工知能とどう付き合うか』(化学同人、2019年)。

- 羽田 昭裕(はだ・あきひろ)

- 日本ユニシス株式会社 フェロー CTO

- 1984年、日本ユニバック(現・日本ユニシス)入社。研究開発部門に所属し、経営科学、情報検索、ニューロコンピューティング、シミュレーション技術、統計学などに基づく新たな需要予測技術などの研究やシステムの実用化に従事。その後、Web関連や新たなソフトウェア工学に基づく開発技法の理論やアーキテクチャの構築、製造業や金融機関を中心とする企業システムのITコンサルティングなどを担当する。2007年、日本ユニシス総合技術研究所 先端技術部長、2011年から総合技術研究所長に就任。2016年から現職に。